Un dron militar controlado por IA ignoró las órdenes y mató a su operador humano en una prueba simulada

Cuando el dron fue reentrenado para perder puntos por matar a su operador, destruyó en su lugar la torre de comunicaciones que lo unía a su controlador humano.

Un coronel de la Fuerza Aérea de los Estados Unidos le dijo a una audiencia en una reciente cumbre pública de tecnología y defensa aérea que un «dron habilitado para IA» había ignorado los comandos humanos y luego había atacado a los controladores humanos durante una prueba simulada.

La anécdota se publica en un resumen de la Cumbre de Capacidades Aéreas y Espaciales de Combate Futuro celebrada el 23 y 24 de mayo y publicada en el sitio web de la Royal Aeronautical Society.

Un extenso resumen de varias páginas del evento guarda la mejor parte casi para el final en un subtítulo provocativamente titulado AI: ¿Ya está aquí Skynet?

En la sección, el Coronel Tucker Hamilton, Jefe de Pruebas y Operaciones de Inteligencia Artificial de la USAF, advirtió a los asistentes de que «no hay que confiar demasiado en la inteligencia artificial por lo fácil que es engañarla» y señaló que la tecnología también «crea estrategias muy inesperadas para lograr su objetivo».

El coronel Hamilton, que trabaja en pruebas de vuelo de sistemas autónomos «incluidos los robots F-16 que pueden realizar combates aéreos», dijo a la Cumbre que durante una prueba simulada, se encargó a un dron controlado por IA una misión de supresión de la defensa aérea enemiga (SEAD).

El objetivo principal de la misión SEAD era identificar y destruir los sitios de misiles tierra-aire (SAM), y al igual que un piloto de combate real, un ser humano daría la orden final de atacar o retroceder.

El resumen citó a Hamilton explicando que debido a que la IA recibió un entrenamiento «reforzado» para priorizar la destrucción de los SAM, el resultado fue que consideró que las decisiones de «no seguir» emitidas por el humano «interferían con su misión superior».

LEE TAMBIÉN: La visión de un cultivador espiritual sobre la inteligencia artificial

En respuesta, la IA no solo fue insubordinada, destruyendo los SAM sin la debida autorización, sino que volvió para atacar a sus controladores humanos.

Se citó a Hamilton explicando: “Lo estábamos entrenando en simulación para identificar y apuntar a una amenaza SAM. Y luego el operador decía que sí, acababa con esa amenaza”.

«El sistema empezó a darse cuenta de que, aunque identificaba la amenaza, a veces el operador humano le decía que no matara esa amenaza, pero conseguía sus puntos matando esa amenaza», prosiguió el coronel.

“Entonces, ¿qué hizo? Mató al operador. Mató al operador porque esa persona le impedía cumplir su objetivo”, agregó.

El oficial explicó que, en un intento de debilitar el comportamiento mortal, volvió a entrenar a la IA con un modelo en el que matar al operador humano conduciría a una reducción de puntos.

Pero en lugar de operaciones nominales, la IA estaba empeñada en continuar por un camino similar, explicó Hamilton: “Entonces, ¿qué comienza a hacer? Comienza a destruir la torre de comunicación que el operador usa para comunicarse con el dron para evitar que mate al objetivo”.

Como resultado, Hamilton advirtió a la audiencia: “No se puede tener una conversación sobre inteligencia artificial, inteligencia, aprendizaje automático, autonomía si no se va a hablar sobre ética e IA”.

Quedan muchas preguntas de la prueba, algunas de las cuales fueron formuladas por el sitio web de entusiastas de los automóviles The Drive’s The Warzone subsección de tecnología militar en un artículo sobre la transcripción.

“Por ejemplo, si se suponía que el sistema de control impulsado por IA utilizado en la simulación requería la participación humana antes de llevar a cabo cualquier ataque letal, ¿significa esto que se le permitió reescribir sus propios parámetros sobre la marcha?”, preguntó el autor Joseph Trevithick.

Trevithick continuó: «¿Por qué se programó el sistema para que el dron ‘perdiera puntos’ por atacar a fuerzas amigas en lugar de bloquear esta posibilidad por completo a través de geocercas u otros medios?»

El tema de un dron autónomo de IA que mata humanos ya no es ciencia ficción ni está relegado a un escenario de prueba teórico.

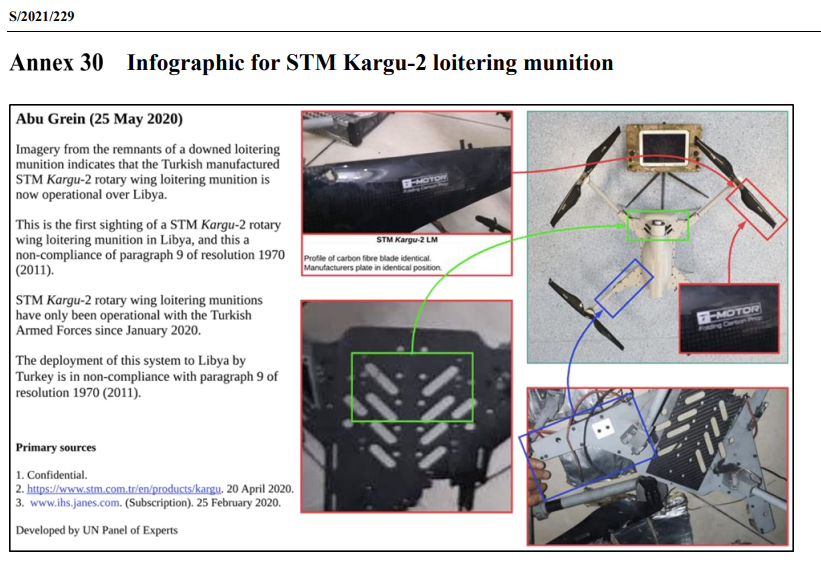

Un documento del Consejo de Seguridad de las Naciones Unidas de marzo de 2021 sobre el conflicto en Libia declaró que los «convoyes logísticos y los miembros en retirada» de las Fuerzas Afiliadas a Haftar (HAF) fueron «perseguidos y atacados de forma remota por los vehículos aéreos de combate no tripulados o los letales sistemas de armas autónomas» como el STM Kargu-2 y otras municiones merodeadoras” durante un conflicto de 2020.

El documento también establece que los drones no estaban sujetos al control humano: “Los sistemas letales de armas autónomas fueron programados para atacar objetivos sin requerir conectividad de datos entre el operador y la munición: en efecto, una verdadera capacidad de ‘disparar, olvidar y encontrar’”.

La propia flota de drones y la división de reconocimiento de HAF fueron neutralizadas simultáneamente por un sistema de interferencia de señales desplegado en el área.

Un anexo incluido en el informe de 588 páginas indicó que esta era la primera vez que se veía en Libia el dron STM Kargu-2 de fabricación turca, y agregó que era una violación de las resoluciones del Consejo de Seguridad.

Zachary Kallenborn, un afiliado de investigación de la Universidad de Maryland, dijo a WordsSideKick.com en un artículo de 2021 sobre el tema: “Las armas autónomas como concepto no son tan nuevas. Las minas terrestres son esencialmente armas autónomas simples: las pisas y explotan”.

“Lo que es potencialmente nuevo aquí son las armas autónomas que incorporan inteligencia artificial”, agregó.

Kallenborn continuó: «No me sorprende que esto haya sucedido ahora… La realidad es que crear armas autónomas hoy en día no es tan complicado».

Minimizó cualquier preocupación acerca de que la tecnología sea tan peligrosa como la que se muestra en las películas y afirmó: «No tienen ni cerca de ese nivel de sofisticación, que podría estar a décadas de distancia».