¿Cómo saber si una imagen es deepfake o real? Experto da tips para no caer en montajes hechos con IA

Tras el aumento de aplicaciones con Inteligencia Artificial que imitan los rostros o voces de personas, con el fin de crear fotografías, videos o grabaciones falsas, es importante tener claras las señales que dejan estas herramientas para poder identificar lo verdadero de lo falso.

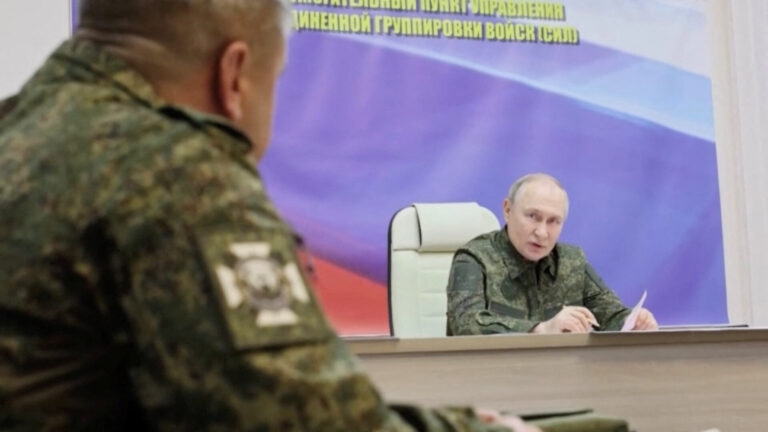

Actualmente, la tecnología deepfake ya no es un avance al que sólo tienen acceso las grandes empresas de producción cinematográfica, sino que está al alcance de todas las personas. Imágenes, videos o grabaciones hechas con Inteligencia Artificial (IA) han sido usadas para los más (oscuros) objetivos que la mera entretención, como la suplantación de identidad, elaboración de información falsa, fraudes, estafas y montajes políticos para manipular la opinión de las personas, entre otros propósitos.

En conversación con BioBioChile, el subdirector del Centro de Datos e Inteligencia Artificial (CDIA) de la Universidad de Concepción, Manuel Pérez, explicó los riesgos de la proliferación de deepfakes, identificó algunas señales o inconsistencias en los modelos de la IA y entregó consejos para no ser víctimas de estos montajes.

La latente amenaza del deepfake

Pocos imaginaron que, con el boom de las aplicaciones de filtros para fotografías y videos, estaría tan cerca la irrupción y acceso público del deepfake. “Una imagen falsa que es generada por modelos de Inteligencia Artificial, entrenados con el fin de reemplazar partes de una imagen, y así, generar una distinta que parezca real”, según el profesional de la UdeC, y que imita casi a la perfección tu apariencia o voz, lo que ha generado un intenso debate a nivel internacional.

Tras la gran cantidad de supuestas fotos filtradas de famosas desnudas y videos pornográficos, pareciera que no hay límites en el uso (y abuso) de esta tecnología. La IA ya no es sólo una herramienta útil, sino que también es un arma para esparcir contenido, material e información falsa. ¿Cómo saber si lo que estoy viendo es real o no?

“Uno de sus principales riesgos es la proliferación de desinformación. Y es que, por medio de redes sociales, las noticias falsas o propagandas se pueden esparcir rápidamente. Esto provoca que, a partir de esta desinformación, las personas no puedan distinguir entre lo que es verdad y lo que es mentira, y quienes la usan, pueden obtener ventajas manipulando la opinión pública. Tiene un gran impacto psicológico”, advierte el ingeniero a la presente redacción.

Sin embargo, y a raíz del polémico caso de los estudiantes del colegio Saint George que crearon y difundieron fotos eróticas de sus compañeras (menores de edad) con la ayuda de aplicaciones con inteligencia artificial, el daño a la reputación personal y el aumento de delitos relacionados al deepfake son factores que generan preocupación en la comunidad informática.

“Se pueden generar imágenes, videos y audios de personas diciendo o haciendo cosas, pero que realmente nunca sucedió, y por otro lado, se puede incitar a la población a caer en fraudes y estafas”, recalca el especialista.

Según un informe de la compañía de seguridad Kaspersky, el 72% de la población no es capaz de distinguir una imagen hecha a partir de un deepfake.

¿Cómo identificar lo real de lo falso?

Pese a la gran cantidad de aplicaciones que brindan la oportunidad de crear una imagen, video o grabación asistido por una Inteligencia Artificial, las herramientas a las cuales tienen acceso la gran parte de la población -ya sean gratuitas o pagadas- suelen tener bastantes limitaciones e inconsistencias que se logran apreciar si analizamos minuciosamente cada detalle de estos montajes.

Es por ello que el experto del CDIA señala que la principal recomendación para no caer en un material audiovisual falso es examinarlo, ya que fácilmente “se pueden encontrar algunas características que evidencian su falsedad, como en el pelo, la textura del rostro, las sombras y los patrones de luces“.

“Los mejores modelos aún siguen teniendo inconsistencias en la generación de datos, como en las expresiones faciales o gestos que no son naturales. Además, también falta que estos modelos entiendan factores culturales propios de cada país y son difíciles de procesar en tiempo real, por lo que siempre son videos que han sido grabados con anterioridad”, complementa.

En el caso de las noticias falsas que se viralizan a partir de montajes con IA, Pérez asevera que lo más importante es no confiar sólo en una fuente, sino que explorar otras y verificar si esos hechos ocurrieron realmente, ya que si bien existen “herramientas capaces de detectar estos patrones que han sido diseñados por la propia IA o páginas webs que ayudan a identificarlos”, los deepfakes y las fake news siguen siendo una estrategia para confundir y manipular a la población a conveniencia de ciertos sectores políticos.

Para evitar ser víctima directo de deepfake, Manuel Pérez aconseja:

– Manejar personalmente y tener resguardos respecto de tu presencia online.

– Cuidar tus restricciones de privacidad.

– Evitar tener perfiles públicos o acceso a tu contenido personal en redes sociales.

– Ser cuidadoso con lo que compartes.

– No aceptar a cualquier persona en redes sociales.

– Leer y estar atentos a los términos y contrato que uno acepta a la hora de descargar una aplicación.

– Evitar las aplicaciones que accedan a tus datos personales, fotografías y videos.

Fuente: BioBio Chile